1、先构造一个只有一层的神经网络:wang= NetChain[{ElementwiseLayer[Sin]}]

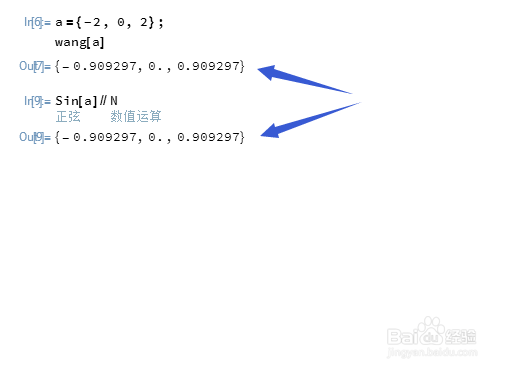

2、这个神经网络的作用是:接收tensor,然后让Sin函数作用于tensor的每一个元素,并把作用结果以新的tensor的形式输出。比如,输入:a={-2, 0, 2};那么,wang[a]就相当于Sin[a]。

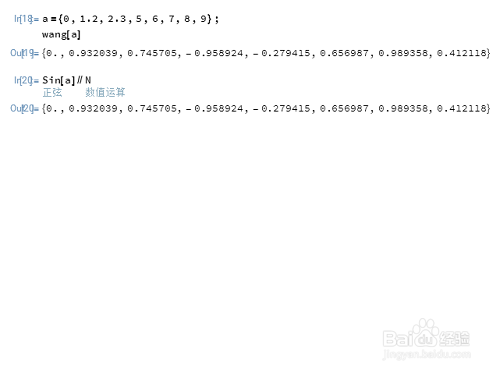

3、换一个tensor:a={0,1.2,2.3,5,6,7,8,9}效果也是相同的。

4、下面构造一个两层的神经网络:wang2= NetChain[{ElementwiseLayer[Sin],SummationLayer[]}]

5、这个网络的作用是:接收tensor、Sin作用与tensor的每一个元素,得到新的tensor、把新的tensor里面的元素加到一起,得到一个实数、输出这个实数。比如:a={0,1.2,2.3,5,6,7,8,9};wang2[a]

6、而Sin[a]//Total//N也能得到同样的结果。