1、方法一:

通过百度网址,进入百度搜索引擎页面(https://www.baidu.com/)

2、在搜索框里面随便输入你想搜索的信息

如果出现这段文字:“由于该网站的robots.txt文件存在限制指令(限制搜索引擎抓取),系统无法提供该页面的内容描述 - 了解详情”

3、鼠标移到了解详情,左键单击 --> 进入了解详情页面

4、可以输入你想要了解的网站的网址

我们在这里输入百度的网址,https://www.baidu.com/,输入之后点击检测

5、可以看到下面的文本框出现了很多的脚本语言,在这里我们详细解释下他们的意思

6、User-agent: Baiduspider(描述了搜索爬虫的名称,这里为Baiduspider,代表设置的规则是对百度爬虫是有效的,如果有很多条的User-agent:,就会有多个爬虫会受到限制)

Disallow: /baidu(指定了不允许抓取的目录,如果只为/,则表示不允许抓取所有页面)

注意:其他的测试链接可能还会有 Allow

Allow: /s?(用来排除某些限制,一般是和Disallow一起使用,不会单独使用)

7、方法二:

浏览器上直接输入:https://ziyuan.baidu.com/robots/index

也可以进入

8、方法三:

在搜索引擎(https://www.baidu.com/)上,直接搜索百度资源

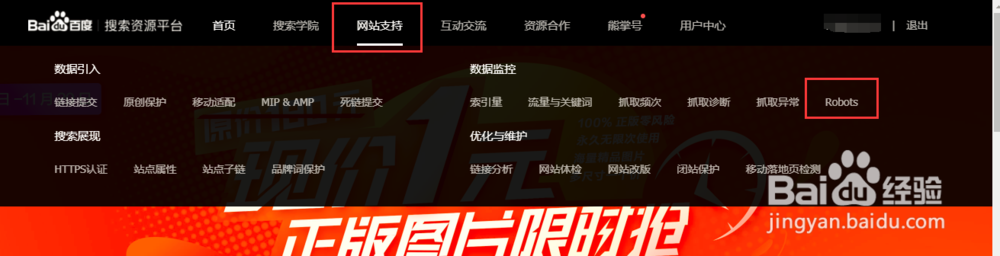

9、进入百度资源之后 --> 网站支持 --> 最右边的Robots

10、进入Robots文件检测页面